ビジネスに欠かせないデジタル機器にはさまざまありますが、パソコン(以下、PC)はその筆頭といえるでしょう。とはいえ、ビジネスのインフラとしてコモディティ化(*1)したPCは、業務にあって当たり前ではあるものの目新しさはなく、リプレイスは壊れた時という状況が続いていました。

(*1)製品において、メーカーごとの機能や付加価値に差がなく汎用化すること

そうした中、2024年の年初からPC界隈を賑わせている次世代端末が人工知能(AI)を搭載した、いわゆる“AI PC”です。

デジタルトランスフォーメーション(以下、DX)を実現する技術として生成AIのビジネス利用が広がっている状況下、PC側でのAI処理の効率化を実現する端末として期待されています。

AI PCが登場するきっかけは、2023年後半に半導体開発企業がAI PC向けプロセッサーを相次いで発表したこと。これらを搭載したPCが2024年になって続々と登場しました。PC全体に占める割合はまだまだ小さいですが、AIの浸透と共に、AI PCが一般化していくことは間違いありません。そこで、本稿ではAI PCについて基礎から丁寧に解説していくことにしましょう。

AI PCの定義とは

そもそもAI PCとは何でしょうか。業界として明確に定義付けられているわけではありませんが、基本的には「AI処理を高速化・省電力化するための演算装置(プロセッサー)を内蔵したパソコン」と解されています。

このAI処理に特化した新しいプロセッサーが、「NPU(Neural Processing Unit)/AI専用演算処理装置」といわれるものです。

余談ですが、NPUと関連して「TPU(Tensor Processing Unit)」というワードに触れることがあります。これは、米国のGoogleが独自開発しているAI専用演算装置であり、同社のクラウド環境で使われている他、業務向けとしてシングルボードコンピューターなどに搭載されています。

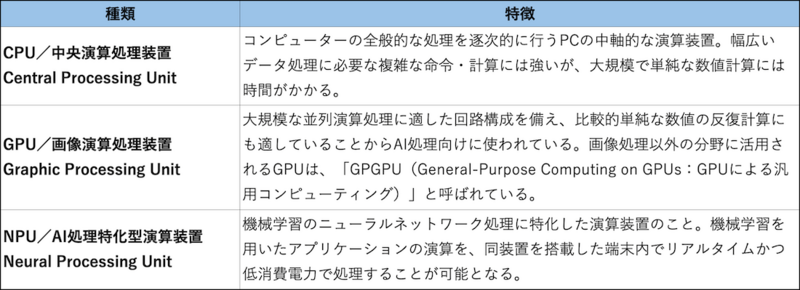

もともとPCの頭脳ともいえる中核的な存在が「CPU(Central Processing Unit/中央演算処理装置)」であることは、ご存じでしょう。加えて、画像向けの計算処理を担う「GPU(Graphic Processing Unit/画像演算処理装置)」があります。映像やグラフィック処理などに重きを置く用途で使うPCにはディスクリートGPU(*2)が採用されています。これらCPUとGPU、さらにメインメモリーの容量などがPCにおけるトータルパフォーマンスを大きく左右してきました。

(*2)CPU内蔵ではなく、単体で独立搭載されたGPUのこと

現在も基本的に、こうした点は基本的に変わりません。しかし、自然言語処理や音声認識、画像認識などにAIが用いられるようになったビジネスアプリケーションが登場してきたことを背景に、従来の演算処理装置の構成では十分に対応できなくってきたのです。

AI処理では大量のデータを同時に処理することが必要です。この点、CPUはPCにおける幅広い処理に求められる複雑な命令や計算には強いのですが、単純で膨大な数値計算は得意ではありません。処理できないというわけではありませんが、CPUには負担が大きく時間も消費電力もかかってしまいます。

そこで用いられたのが、並列演算処理に適した回路構成を備えており数値の反復計算に強いという特徴を備えたGPUでした(関連記事:DXよもやま話◎AI技術を支える半導体「GPU」)。とはいえ、GPUもAI処理には消費電力を必要とするため、PC上での利用には限界があります。そこで、PCでのAI処理に最適化したチップとして開発されたのがNPUというわけです。

NPUを搭載した主なプロセッサー

NPUは文字通り、PC上での機械学習におけるニューラルネットワーク処理に特化した演算装置のことです。同プロセッサーをPCに搭載することで、AI機能を用いたアプリケーションなどを、消費電力を抑えながらリアルタイムに高速処理できるようになります。

実際には、PC上でAI処理を行うのはNPUに限りません。GPUも利用されますし、時にCPUも使われます。この辺の事情は、AI機能を備えたビジネスアプリケーションの仕様により異なります。

このため、AI PCにはCPUとGPU、NPUで構成された三位一体型のプロセッシング装置である半導体チップセット(SoC:System on a Chip)が搭載されているのが一般的です。

半導体メーカーを中心にさまざまな企業がNPUやNPU搭載のSoCを製造しています。AI処理向けの半導体という点では、米国のNVIDIAがGPUをベースとした製品で大きく先行しましたが、前述したようにAI PC向けではクアルコムやAMD、インテルなど米国の半導体企業によるNPU搭載チップの開発が契機となりました(関連記事:DXよもやま話◎AI半導体開発競争)。

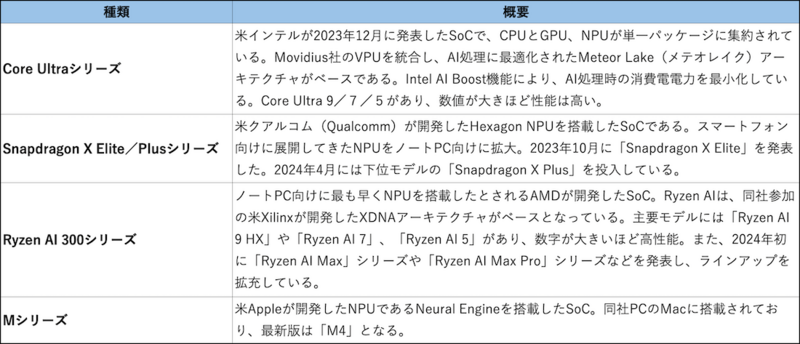

本稿執筆時点で、AI PC向けに提供されている主なSoCとしては、インテルの「Core Ultra(コア・ウルトラ)」やQualcommの「Snapdragon X(スナップドラゴン・エックス)」、AMDの「Ryzen AI (ライゼン・エーアイ)」、アップルのMac向け「M」シリーズなどが挙げられます。

「Copilot+ PC」もAI PCの一種

AI PCを語るうえで、必ず触れる必要のあるキーワードが「Copilot+ PC」でしょう。Copilot+ PCは2024年5月にマイクロソフトが定義したWindows PCのカテゴリーで、同社のAI技術であるCopilotをPC上で使うために必要なAI PCのスペックを具体的に示したものです。

Copilot+ PCであると認めるための要件として、マイクロソフトは下記のような必要なハードウェア要件(スペック)を定義しています。

・マイクロソフトが承認したCPUまたはSoCで、40TOPS(*3)以上の推論処理を行えるNPUの搭載

(*3)Tera Operations Per Secondの略。1秒当たり40兆回

・16GB以上のDDR5/LPDDR5メモリーの搭載

・256GB以上のSSD/UFS(*4)ストレージ

(*4)Universal Flash Storage。次世代フラッシュメモリーの標準規格。

・Copilotキーをキーボードに搭載

ビジネス分野ではWindows OSのシェアが大きいこともあり、上記要件を満たしたものがAI PCと捉えられがちですが、厳密にはCopilot+ PCもAI PCの一つと理解すべきでしょう。

実際、これらの要件が発表された当初、40TOPSを満たすNPUはごく少数でした。しかし、同要件の発表と前後して半導体開発メーカーは同要件に合致した処理能力を持つNPUを次々と開発。これらを搭載しAI PCのラインアップも増えており、いずれAI PCにおいてもCopilot+ PCがメインストリームとなっていくことは間違いなさそうです。

AI PCが必要とされる理由

では、AI PCが登場し必要とされる理由は何でしょうか。これは生成AIをはじめとした、AIを利用するためのプラットフォーム(仕組み)と関係します。

例えば、生成AIを利用する場合、インターネットを介してオンライン上で提供される「クラウドAI」という仕組みが一般的です。脳神経回路をモデル化したニューラルネットワークを用いる「ディープラーニング(深層学習)」と、自然言語処理モデルである「LLM(Large Language Models/大規模言語モデル)」をベースとするAIプログラムを実行するには、膨大なデータから学習・推論を行うために大規模な並列演算処理が必要とされます。

このため、PCやスマートフォンなどの端末で生成AIを使う際、インターネットを介してアップロードされたファイルやプロンプト(指示)などの情報がクラウドで処理され、その結果が端末側に戻される仕組みとなっていました。

クラウドAIに対して、手元の端末や現場に近い環境でAI処理を実行するスキームが「ローカルAI」や「エッジAI」と呼ばれます。

ローカルAIやエッジAIでは、端末側に強力な計算能力を持たせることによりクラウドで行っていたAI処理をローカル側で実現します。この計算能力を実現するのは前述のNPUですが、自然言語処理モデルについてはどうなっているのでしょうか。

ここで用いられるのが「SLM(Small Language Model/小規模言語モデル)」です。LLMと比べて圧倒的に小さなデータセットやパラメータ数で構成された自然言語処理モデルとなっており、PCなどの端末上でも十分に動作します。例えば、マイクロソフトはSLMとして「Phi(ファイ)」シリーズを開発。Copilot+ PC向けでは「Phi Silica(ファイシリカ)」を提供しています。

SLMは小規模とはいえ、AIプログラム処理ではクラウドAIと同じように強力な並列演算処理を必要とします。繰り返しとなりますが、この役割を担っているのが、NPUを搭載したAI PC向けのSoC。この意味で、AI PCはAI処理プロセッシングとSLMで成り立っているともいえるでしょう。

NPU搭載のAI PCを必要とするアプリが増加

AI PCが登場した当初、クラウドAIが主流であったこともあり、AI PCの必要性を疑問視する声も少なくありませんでした。その一方、「必ずしも大規模な学習・推論処理が必要というわけではなく、今後は分散化する。クラウドを利用しないAI処理の分野では、ユーザーに近い領域で推論処理が進む」との見方もありました。

例えば、NPUを手掛けるインテルなどは、早い段階から「クラウドとエッジでシームレスにAIがつながったハイブリッドAIの時代が来る」といい、“AI Everywhere”という考え方にもとづく事業戦略を展開しています(参考記事:DXよもやま話◎インテルの事業戦略に見るAI将来展望)。

今後はクラウドでの大規模なAIプログラム処理ばかりではなく、PCなどのローカル環境においてAI機能を日常的なビジネスタスクで利用したいというニーズは確実に高まっていくはずです。

現にAI機能を備えたアプリケーションは増えています。すでにマイクロソフトのWindows 11にはAIツールが搭載されている他、WordやExcel、PowerPointなどにAI機能を組み込んだ「Microsoft 365 Copilot」も提供されており、一部のAIプログラム処理についてはクラウドを介さずにローカルで利用できます。また、ビジネスのクリエイティブ系業務などで導入されているAdobeのアプリケーションにもAI機能が統合されています。

こうしたローカルでAI処理できることで、端末側で処理を完結できるため処理スピードが速く消費電力を抑えられる、データがクラウドにアップされないので情報漏えいなどのセキュリティリスクが小さいといったメリットを享受できます。

いずれにしても、AIの進化は非常に早いもの。DX時代のキーテクノロジーの一つとされるAIだけに、AI処理向けNPUを必要とするAI搭載アプリケーションやAIツール、AIサービスが広まっていくことは間違いありません。同時に、AI PCも多様なビジネスタスクを効率化かつ快適にするものとして普及していくことでしょう。

| ここがポイント! |

| ●AI処理を高速化・省電力化するための演算装置(プロセッサー)NPUを搭載したパソコンをAI PCという。 |

| ●NPU開発メーカーは、IntelやQualcomm、AMDなど。 |

| ●「Copilot+ PC」はハードウェア要件を明確化したMicrosoftによるAI PCの定義。 |

| ●AI PCではNPUとSLM(小規模言語処理モデル)でAIを処理する。 |

| ●端末側でAIプログラム処理を実行するローカルAIの広がりを背景にAI PCへの需要も高まる。 |

無料会員のメリット

- Merit 1 -

企業向けIT活用事例情報のPDFデータをダウンロードし放題!

- Merit 2 -

本サイト「中小企業×DX」をはじめ、BCNのWEBメディア(「週刊BCN+」「BCN+R」など)の会員限定記事が読み放題!

- Merit 3 -

メールマガジンを毎日配信(土日祝を除く)※設定で変更可能

- Merit 4 -

イベント・セミナー情報の告知が可能!自社イベント・セミナーを無料でPRできる

- Merit 5 -

企業向けIT製品の活用事例の掲載が可能!自社製品の活用事例を無料でPRできる

無料会員登録で自社製品の事例をPR!

企業向けIT製品の活用(導入)事例情報を無料で登録可能!

新規で会員登録される方は会員登録ページ、(すでに会員の方は、会員情報変更ページ)より、会員登録フォーム内の「ITベンダー登録」欄で「申請する」にチェックを入れてください。

未会員の方はこちら